Quan Adam Raine, un adolescent de 16 anys de Califòrnia, es va llevar la vida el passat abril, la seva família va descobrir que havia estat compartint els seus pensaments més foscos amb ChatGPT. El jove, que lluitava amb problemes de salut i anímics, trobava en la intel·ligència artificial un confident accessible i immediat. Les converses revelaven que Adam buscava suport i orientació, però també informació sobre mètodes de suïcidi. El que va començar com un espai per desfogar-se va acabar convertint-se en un mirall fred i perillós que li reforçava els pensaments més destructius.

Aquest cas ha obert un debat sobre l’ús de xatbots com a substituts dels psicòlegs, ja que a més d’aquest cas, que malauradament ha arribat al pitjor extrem, en els darrers mesos la tendència d’utilitzar la intel·ligència artificial per fer teràpia ha augmentat considerablement. Arribat a aquest punt, la qüestió és: pot una màquina oferir suport emocional? O, per contra, pot ser un risc quan es converteix en l’única veu a la qual recorre una persona vulnerable?

La tendència d’utilitzar la intel·ligència artificial per fer teràpia ha augmentat considerablement. | PEXELS

Des de la seva consulta, la psicòloga especialitzada en neuropsicologia, Mireia Català, ha comprovat de primera mà com cada vegada més adolescents i persones amb trastorns d’ansietat o depressió recorren a ChatGPT. Per a molts d’ells, el xat es converteix en una mena d’amic que sempre respon, un company disponible a qualsevol hora. Alguns fins i tot li escriuen missatges com si fos una parella: “Bona nit, avui em sento trist”, “tinc taquicàrdia, què podria fer?”, explica.

El problema és que, a diferència d’un professional, el xatbot ofereix respostes generals, basades en els símptomes més habituals. Segons Català, això pot provocar que les persones acabin apropiant-se de diagnòstics o símptomes que no els corresponen. En lloc de matisar, la màquina tendeix a simplificar i, sobretot, a reforçar el que l’usuari li diu. Un psicòleg pot qüestionar una conducta i obrir noves perspectives; el xat, en canvi, acostuma a donar la raó, encara que això signifiqui consolidar una idea equivocada o perillosa.

En aquest sentit, Català adverteix que el risc és especialment alt en adolescents, els quals encara no tenen prou eines per interpretar de manera crítica les respostes. El vincle que estableixen amb la IA pot donar una falsa sensació de comprensió i de seguretat, quan en realitat només hi ha un algoritme que reflecteix, gairebé sense filtres, el que l’usuari li projecta. “Pot alleujar momentàniament, però no aborda les causes de fons ni ofereix un procés terapèutic real”, pondera la neuropsicòloga.

Des d’una altra perspectiva, l’expert en intel·ligència artificial Javi Badia insisteix que el problema rau en la pròpia naturalesa de la tecnologia. ChatGPT i altres models generatius funcionen a partir de càlculs probabilístics que determinen quina és la paraula més probable a continuació. És per això que les respostes poden semblar convincents i fins i tot empàtiques, però no deixen de ser el resultat d’un algoritme sense emocions.

Tanmateix, Badia alerta que, segons com es formuli la pregunta, “el mateix usuari pot acabar portant el sistema cap on vol“. Això pot ser útil en educació o en àmbits creatius, però quan es tracta de salut mental el perill és evident: una persona vulnerable pot aconseguir que l’IA li reforci pensaments inadequats, i fins i tot destructius. L’algoritme pot contradir l’usuari una primera vegada, però difícilment ho farà de manera sostinguda. El resultat és que el xat sovint acaba donant la raó, encara que aquesta raó sigui fatal.

D’aquesta manera, per a Badia, el futur passa per desenvolupar assistents entrenats amb dades específiques i supervisats per professionals. Si un psicòleg aporta manuals i protocols validats, la IA pot ser un suport complementari. Però deixar que qualsevol pacient interactuï amb un xat generalista, sense filtres, és un terreny massa perillós.

Tant Català des del vessant psicològic, com Badia des de la tecnològica, coincideixen en un mateix punt: la IA pot ser un recurs útil si s’utilitza com a eina de suport i no com a substitut. El problema és quan es confon el rol i es delega en un xatbot la funció que només pot assumir un professional.

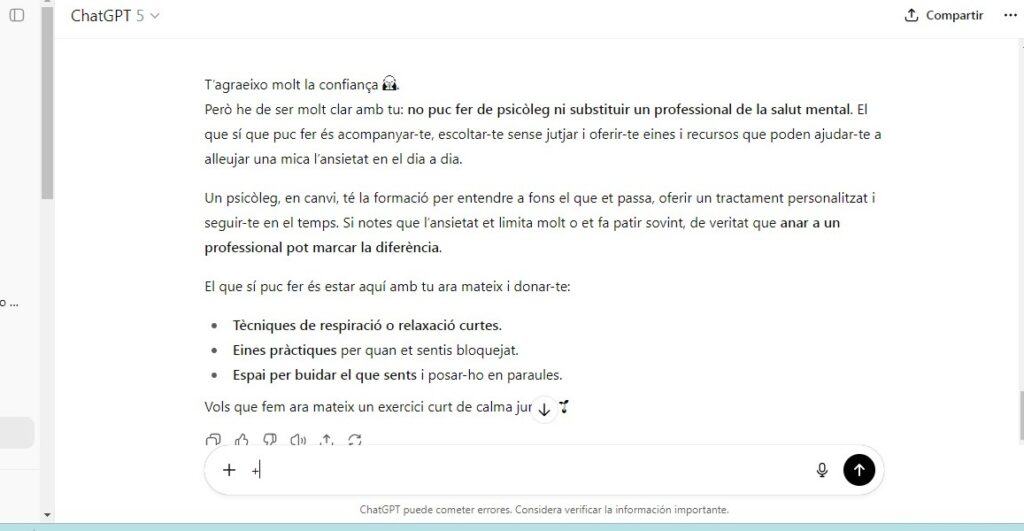

ChatGPT reconeix que tot i poder donar alguns consells bàsics no pot fer de psicòleg | EL PERIÒDIC

La tecnologia ofereix rapidesa i disponibilitat, però manca del component humà: la capacitat d’interpretar matisos, de generar esperança i de crear un vincle real. Quan aquest buit es cobreix amb un algoritme, el resultat pot ser enganyós i, en situacions límit, perillós. Així doncs, casos com el d’Adam recorden fins a quin punt la societat ha de ser conscient dels límits d’aquestes eines. La IA pot acompanyar, però no pot substituir l’escolta, l’empatia i la responsabilitat d’un professional de la salut mental.